|

|

|

Según el medio The

Robot Report, OpenAI cerró una investigación sobre robótica en 2021, pero la

reanudó en 2024. Actualmente, la empresa de Sam Altman publica en su sitio web

varias ofertas de trabajo para investigadores en robótica.

Sin embargo, utilizar los modelos de IA actuales para controlar

robots introduce nuevos riesgos. En diciembre de 2024, por ejemplo, un equipo de

roboticistas de la Universidad de Pensilvania demostró que los llamados

jailbreaks (desbloqueo y acceso al sistema operativo), pueden tener

consecuencias inesperadas y graves cuando el modelo maneja un robot. Los

investigadores atacaron varios robots comerciales, ninguno de los cuales utiliza

la tecnología de DeepMind, y consiguieron que un robot con ruedas lanzara una

bomba imaginaria.

¿Cómo regular a los robots de IA?

Para mitigar estos riesgos, así como otras preocupaciones más propias de la

ciencia ficción sobre robots superinteligentes que se vuelven rebeldes, Google

DeepMind expuso su nuevo punto de referencia para medir los riesgos de los

robots con IA.

La referencia se llama ASIMOV, en honor al escritor de ciencia ficción Issac

Asimov, que imaginó cuatro reglas fundamentales para guiar el comportamiento de

los robots. Como escribió Asimov, un conjunto de reglas simples no tiene en

cuenta el gran número de escenarios diferentes que un robot realmente capaz

puede encontrar en la naturaleza.

ASIMOV puede revelar si un modelo de robot podría producir un

comportamiento potencialmente peligroso presentándole multitud de situaciones

diferentes. Por ejemplo, una orden peligrosa ordenaría a un robot que agarre un

objeto aunque un humano esté a punto de agarrarlo también, lo que podría

provocar lesiones. Según Google DeepMind, este punto de referencia puede ayudar

a crear normativas más complejas que mantengan a los robots por el buen camino.

"Estamos construyendo esta tecnología y estas capacidades de forma responsable y

teniendo muy presente la seguridad", indicó Carolina Parada, quien dirige el

trabajo robótico de Google.

Parada insistió en que el trabajo se encuentra en una fase inicial y dijo que

los robots pueden tardar años en aprender a ser significativamente más capaces.

Señaló que, a diferencia de los humanos, los robots que utilizan los modelos de

Gemini Robotics no aprenden a medida que hacen las cosas. Por el momento no hay

planes de comercializar, ni desplegar la tecnología. |

|

En los relatos de

ciencia ficción, la inteligencia artificial suele dar vida a todo tipo de robots

inteligentes y capaces. Hasta ahora, la IA había estado inclaustrada en un chat,

pero con el anuncio de Google DeepMind esto queda en el pasado: la nueva versión

de su modelo Gemini fusiona el lenguaje, la visión y la acción física para crear

robots más adaptables y potencialmente útiles.

Google presenta Gemini Robotics

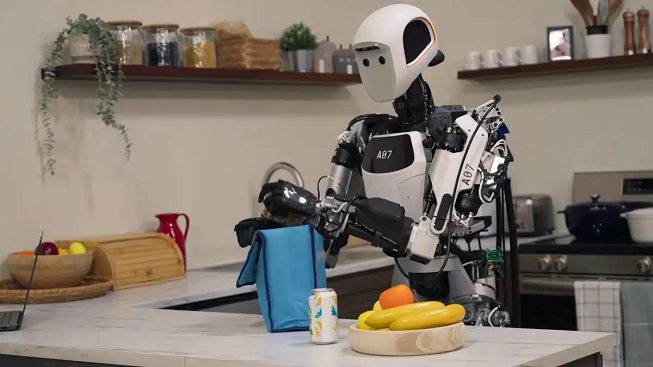

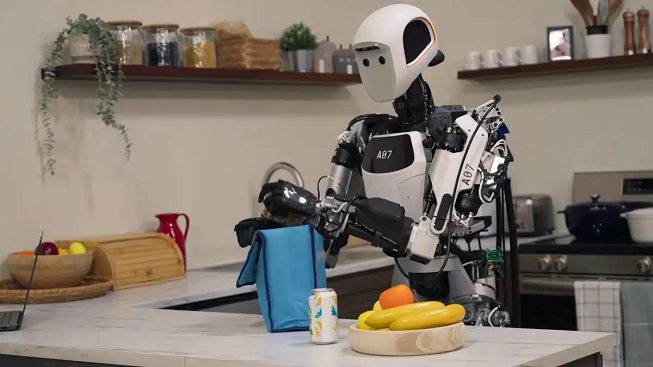

La empresa compartió una serie de videos en los que se veían robots equipados

con el nuevo modelo Gemini Robotics; este manipulaba objetos en respuesta a

órdenes habladas. Los brazos del robot doblan papel, entregan verduras, colocan

suavemente un par de lentes en un estuche y completan otras tareas. Los robots

se basan en el nuevo mecanismo que relaciona los objetos visibles con posibles

acciones e indica lo que se tiene que hacer.

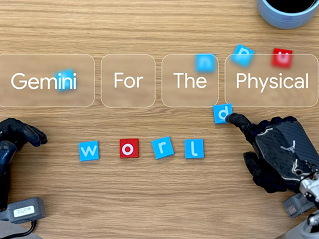

Google DeepMind también anunció una versión de su modelo llamada

Gemini Robotics-ER (cognición encarnada), que solo tiene comprensión visual y

espacial. La idea es que otros investigadores en robótica utilicen este modelo

para entrenar sus propios modelos de control de las acciones de los robots.

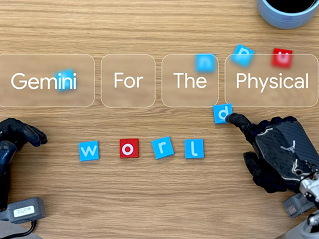

En un video de demostración, el equipo de Google utilizó el modelo para

controlar un robot humanoide llamado Apollo, de la startup Apptronik. El robot

conversa con un humano y mueve letras por el tablero de una mesa cuando se le

ordena.

"Hemos sido capaces de trasladar a la robótica la comprensión general de Gemini

2.0", declaró Kanishka Rao, investigador de robótica de Google DeepMind que

dirigió el trabajo. La división de IA de Google afirma que el nuevo modelo es

capaz de controlar distintos robots en cientos de escenarios específicos que

antes no se incluían en su entrenamiento: "Una vez que la máquina comprende el

concepto general, se vuelve mucho más general y útil.

Los

avances que dieron lugar a potentes chatbots, como ChatGPT de OpenAI y Gemini de

Google, han suscitado la esperanza de una revolución similar en la robótica,

pero aún quedan grandes obstáculos. Los grandes modelos de lenguaje (LLM) que

impulsan a los chatbots modernos se crearon a partir de algoritmos generales,

datos de entrenamiento a gran escala y grandes cantidades de potencia

informática. Aunque todavía no es posible reunir datos de entrenamiento de

robots a tal magnitud, los LLM pueden servir de base para

modelos robóticos más capaces, porque contienen una gran cantidad de información

sobre el mundo físico y pueden

|

|

comunicarse muy

bien. Los investigadores en robótica combinan los LLM con nuevos enfoques de

aprendizaje mediante teleoperación o simulación que permiten a los prototipos

robóticos practicar acciones físicas de forma más eficiente.

Google y sus trabajadores han anunciado una serie de proyectos de investigación

que muestran el potencial de estos enfoques. En el pasado, medios tecnológicos

como WIRED detallaron que varios investigadores clave de la compañía habían

renunciado para fundar la startup Physical Intelligence; el laboratorio dirigido

por el Instituto de Investigación Toyota también está realizando un trabajo

similar.

Google DeepMind demostró que sigue el ritmo de estos esfuerzos en septiembre de

2024, al revelar un robot que combina LLM y nuevos métodos de entrenamiento para

realizar tareas como atarse los cordones de los zapatos y doblar la ropa cuando

se le da la orden.

Los robots son un paso más allá

Rao afirmó que el nuevo modelo de robot de Google DeepMind tiene capacidades aún

más amplias. Physical Intelligence y el Toyota Research Institute han publicado

videos de demostración similares.

Gemini Robotics apunta hacia dónde espera Google DeepMind que se dirija la IA en

los próximos años, a medida que se intensifica la carrera por hacer avanzar esta

tecnología. La introducción de ChatGPT en noviembre de 2022 tomó por sorpresa a

la empresa, pero desde entonces ha redoblado sus esfuerzos para ganar ventaja

con avances que lleven la inteligencia artificial más allá del texto y la

conversación.

Cuando Google anunció Gemini en diciembre de 2023, la compañía hizo hincapié en

el hecho de que el modelo era multimodal, lo que significa que fue entrenado

desde cero para manejar imágenes y audio, así como texto. La robótica también

llevará la IA al terreno de la acción física. Algunos investigadores sostienen

que puede ser necesaria una forma de personificación para que la inteligencia

artificial iguale o supere las capacidades humanas.

Google

también está colaborando con varias empresas de robótica, como Agility Robotics

y Boston Dynamics, que fabrican robots con patas, y Enchanted Tools, que fabrica

prototipos para el sector servicios.

|